Robots.txt richtig nutzen und Google-Rankings boosten

Die robots.txt ist deine Geheimwaffe, um Suchmaschinen zu steuern und nur die besten Inhalte deiner Seite sichtbar zu machen. Erfahre, wie du unnötiges Crawling vermeidest und mehr organischen Traffic aufbaust.

Robots.txt: Deine Geheimwaffe für bessere Google-Rankings

Die robots.txt ist ein wichtiger Teil jeder Website-Strategie, doch viele wissen gar nicht, wie sie richtig genutzt wird. Lass uns direkt klären, was es mit der robots.txt auf sich hat und wie sie dir helfen kann, deine Website besser ranken zu lassen.

Was ist die robots.txt?

Stell dir die robots.txt wie einen Türsteher für deine Website vor. Sie entscheidet, welche Teile deiner Website von Suchmaschinen gecrawlt werden dürfen und welche nicht. Das ist extrem wichtig, um zu vermeiden, dass unwichtige oder sensible Seiten gecrawlt werden und unnötige Serverressourcen verbraucht werden. Bei TopRank Agentur nutzen wir unsere 15 Jahre Erfahrung im SEO, um die robots.txt genau an die Bedürfnisse unserer Kunden anzupassen. Schau dir gerne unsere Gratis SEO und GMB Analyse an, wenn du mehr wissen willst.

Die wichtigsten Teile der robots.txt

- User-Agent-Direktiven: Damit gibst du an, für welche Bots die Regeln gelten. Zum Beispiel für Googlebot oder einfach für alle Bots mit einem „*“.

- Disallow-Regeln: Diese Regeln verhindern, dass bestimmte Seiten gecrawlt werden, z.B. „Disallow: /admin/“. So bleibst du flexibel, was die Sichtbarkeit von Seiten angeht.

- Allow-Regeln: Das genaue Gegenteil von Disallow. Wenn du z.B. eine gesamte Kategorie blockiert hast, aber eine spezifische Seite erlaubt sein soll, kannst du dies hier festlegen.

- Sitemap-Deklaration: Mit der Sitemap zeigst du den Bots, wo sie die Struktur deiner Seite am schnellsten verstehen können.

- Crawl-Delay-Parameter: Falls du Bots sagen willst, wie lange sie zwischen Anfragen warten sollen. Google ignoriert das meistens, aber für andere Suchmaschinen kann es sinnvoll sein.

Warum eine gute robots.txt so wichtig ist

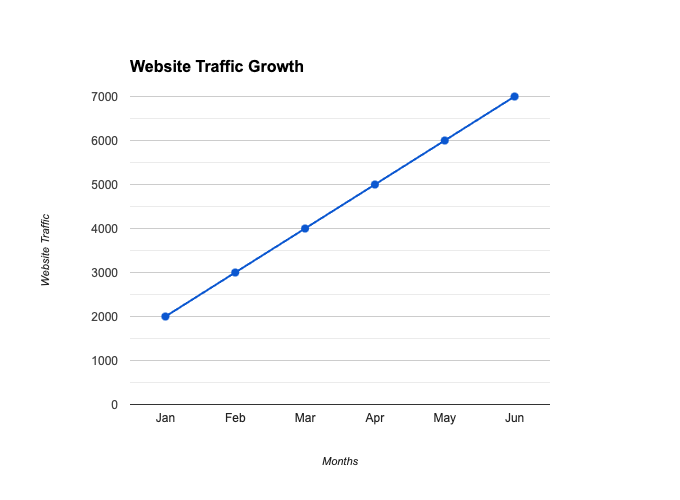

Eine gut strukturierte robots.txt-Datei hilft dir dabei:

- Nur relevante Seiten in den Suchergebnissen anzuzeigen

- Serverressourcen zu schonen, indem unnötige Seiten nicht gecrawlt werden

- Die Indexierungsrate wichtiger Seiten zu verbessern

Und hier ein praktisches Beispiel: Ein E-Commerce-Unternehmen konnte seinen organischen Traffic um 54% steigern, nachdem es seine robots.txt optimiert hat (Quelle: Search Engine Journal, 2022).

Häufige Fehler in der robots.txt

Viele Websites haben Fehler in ihrer robots.txt-Datei. Laut einer Analyse von Ahrefs (2023) haben 45% der Top-100.000-Websites Fehler, die die Crawlbarkeit einschränken. Hier sind die häufigsten Fehler:

- Wichtige Seiten versehentlich blockieren: Ein falscher Disallow-Eintrag und deine wichtigsten Seiten können plötzlich nicht mehr gecrawlt werden.

- Fehlende Sitemap-Deklaration: Ohne eine korrekt angegebene Sitemap dauert die Indexierung länger.

- Falsche User-Agent-Direktiven: Stell sicher, dass du die Regeln richtig für die relevanten Bots konfigurierst.

Mehr dazu findest du in unserem Beitrag über Crawlbarkeit, in dem wir erklären, wie man sicherstellt, dass Bots auf deiner Seite tun können, was sie sollen.

Tipps für eine erfolgreiche robots.txt

Damit deine robots.txt-Datei das Beste aus deiner Website herausholt, befolge diese Tipps:

- Verwende spezifische User-Agent-Direktiven, um Bots gezielt zu steuern

- Disallow nutzlose Seiten wie „Admin“, „Login“ oder andere nicht relevante Bereiche

- Vergiss nicht die Sitemap-Deklaration

- Teste die robots.txt mit Tools wie dem Google-Tool für robots.txt-Tester

Weitere hilfreiche Informationen zur robots.txt findest du auch auf Moz und Yoast.

FAQs zur robots.txt

Was passiert, wenn ich keine robots.txt habe?

Wenn du keine robots.txt hast, können Suchmaschinen standardmäßig auf alle öffentlichen Seiten zugreifen. Das ist in den meisten Fällen kein Problem, kann aber zu unnötigem Crawling führen.

Kann ich mit der robots.txt mein Ranking verbessern?

Indirekt, ja. Eine gut konfigurierte robots.txt kann dazu beitragen, dass die richtigen Seiten in den Suchergebnissen erscheinen und unwichtige Seiten ausgeschlossen werden. Das verbessert die Gesamtqualität der Indexierung.

Wie oft sollte ich meine robots.txt überprüfen?

Mindestens einmal im Jahr oder nach größeren Änderungen an deiner Website-Struktur. Vergiss nicht, dass Fehler hier schnell teuer werden können.

Fazit

Die robots.txt ist ein einfaches, aber effektives Werkzeug, um die Kontrolle über deine Website zu behalten. Nutze sie, um sicherzustellen, dass Suchmaschinen die richtigen Seiten deiner Website crawlen. Falls du dir unsicher bist, wie du deine robots.txt optimieren kannst, stehen wir bei der TopRank Agentur dir gerne zur Seite. Klick hier für eine gratis SEO und GMB Analyse.

Für noch mehr SEO-Tipps schau dir auch unseren Beitrag zur Verwendung von Long-Tail-Keywords an, um deine Rankings weiter zu verbessern!